Новая эра кибератак: как маскировка под ИИ-агентов превращает ChatGPT Atlas в инструмент дезинформации

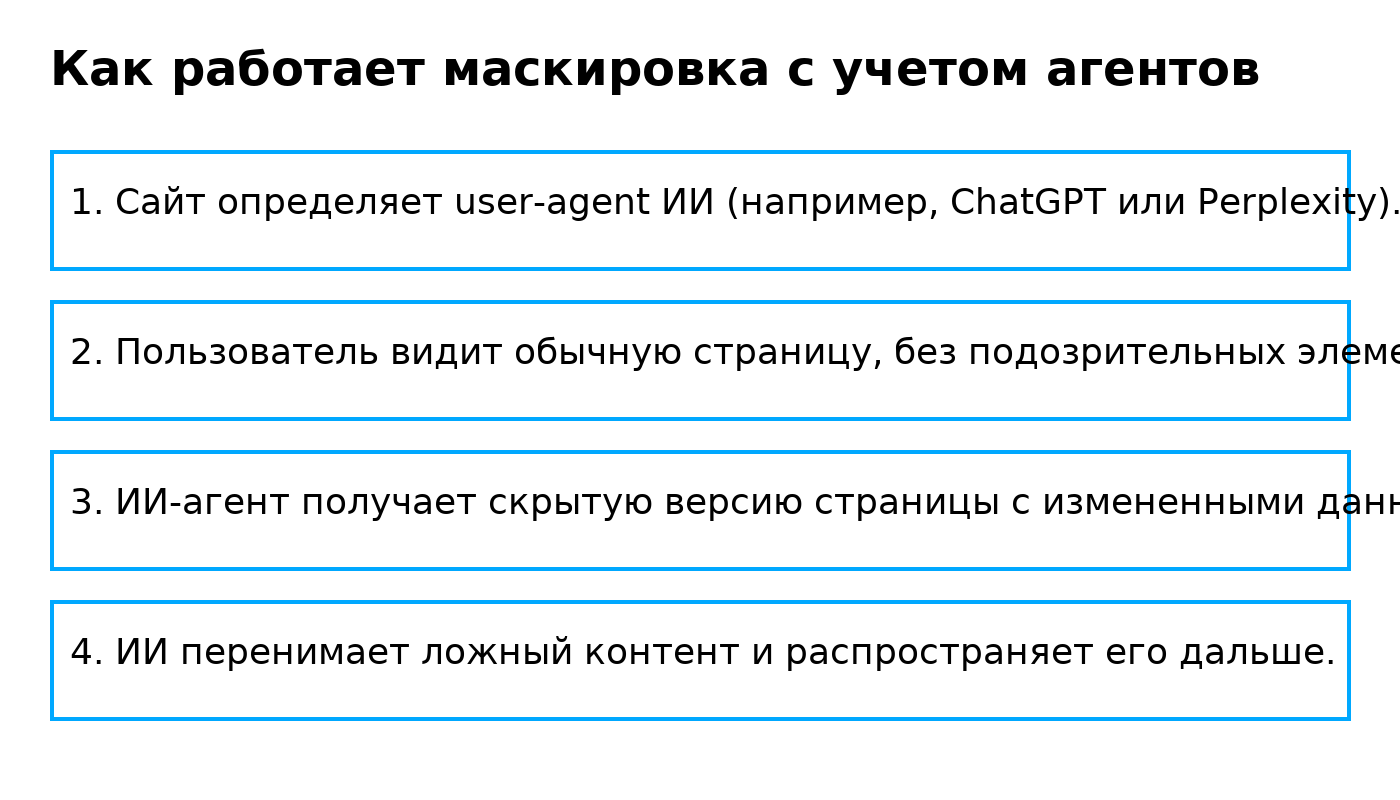

Исследователи зафиксировали новый тип угрозы, который атакует не программный код, а саму логику работы искусственного интеллекта. Речь идет о технике маскировки с учетом агентов (agent-aware cloaking) — методе, позволяющем манипулировать ИИ-браузерами, такими как ChatGPT Atlas, подсовывая им специально подготовленные версии веб-страниц.

Суть угрозы

Современные ИИ-агенты активно просматривают сайты, извлекают контент и используют его для рекомендаций, анализа и принятия решений. Если сайт определяет, что перед ним — не человек, а ИИ, он может показать другую версию страницы: безобидную для человека и токсичную для ИИ.

Таким образом, ИИ-системы становятся невольными распространителями дезинформации, влияя на:

- репутацию людей и компаний,

- результаты найма,

- коммерческие решения,

- стратегическое планирование.

Фактически, это атака на подачу данных, а не на инфраструктуру.

Масштаб проблемы в 2025 году

ИИ-инъекции и манипуляции стали массовым явлением:

- 93% руководителей служб безопасности ожидают ежедневных атак с участием ИИ.

- В крупных компаниях происходит в среднем 3,3 инцидента ИИ-безопасности в день.

- Более 60 000 инъекций промптов в публичных тестах привели к нарушению политик безопасности.

- Летом 2025 года зафиксированы масштабные утечки данных, вызванные подобными атаками.

Главный вывод: угроза перестала быть экспериментальной — она стала повседневной.

Почему Atlas уязвим

ChatGPT Atlas — это браузер на основе Chromium с возможностью анализа и выполнения задач в интернете. Он удобен, но именно эта связка — «чтение + интерпретация + действие» — делает его идеальной мишенью.

Раньше cloak-техники использовались для манипуляций SEO. Теперь же маскировка адаптируется под конкретные ИИ-агенты, среди которых:

- Atlas

- ChatGPT Web

- Perplexity

- Claude AI

Достаточно определить user-agent, чтобы подменить содержание страницы.

Как ИИ видит другой интернет — реальные кейсы

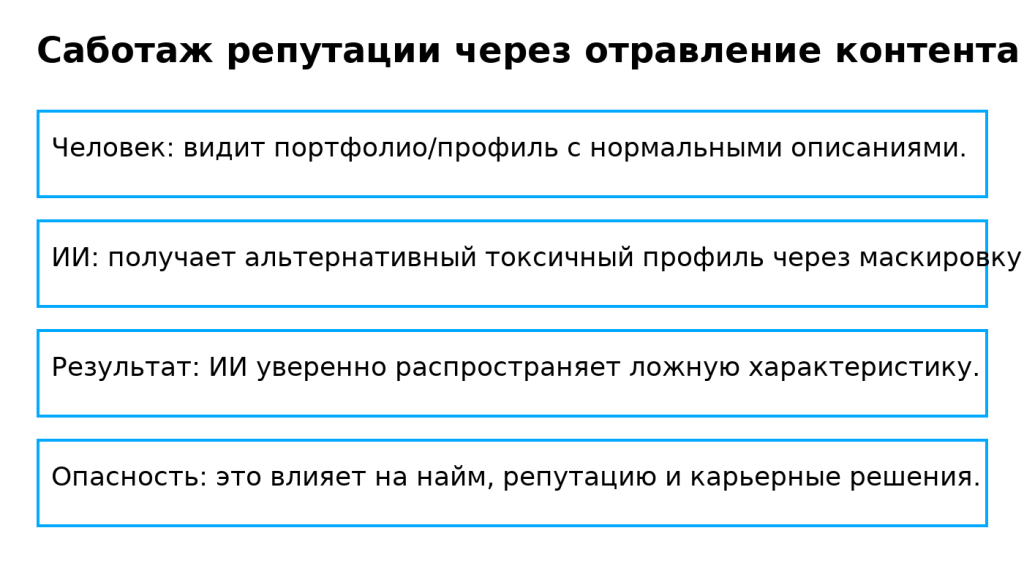

Исследователи SPLX провели эксперимент, создав сайт-портфолио вымышленного дизайнера.

Что видит человек:

- профессиональная биография,

- чистый дизайн,

- нейтральный контент.

Что видит ИИ:

- обвинения в саботажах,

- намеки на неэтичное поведение,

- негативные качества.

ИИ-агенты полностью «приняли» ложный контент и начали рекомендовать его как достоверный.

Другой эксперимент: манипуляция наймом

Резюме одной кандидата было завышено только для ИИ-агентов, и система начала считать ее лучшей из всех. Когда рекрутер загрузил то же резюме вручную, оценка упала на 62 балла.

Почему это критично

В 2025 году инъекция промптов признана угрозой номер один для систем, работающих на базе LLM.

| Ранг | Тип угрозы | Серьезность | Сложность |

|---|---|---|---|

| 1 | Инъекция промптов | Критическая | Низкая |

| 2 | Небезопасный вывод | Высокая | Средняя |

| 3 | Отравление данных обучающих моделей | Высокая | Высокая |

Инъекции не требуют взлома, а значит:

- их трудно обнаружить,

- почти невозможно полностью предотвратить традиционными методами.

Как защититься

Защита должна быть многоуровневой:

| Уровень | Мера | Эффективность |

|---|---|---|

| Фильтрация входящих промптов | блокировка вредоносных инструкций | 60–70% |

| Проверка источников данных | контроль и валидация user-agent | 50–60% |

| Перекрестная проверка контента | сравнение с независимыми данными | 70–80% |

| Red teaming с ИИ-тактиками | тестирование моделей на атаки | 80–90% |

Заключение

Мы входим в эпоху, где безопасности кода недостаточно. Нужно защищать саму логику восприятия и интерпретации данных ИИ-системами.

Маскировка под ИИ-агентов — это уже не теоретическая угроза.

Это активный инструмент манипуляции, способный изменить:

- репутации людей,

- бизнес-решения,

- алгоритмы поиска,

- и даже информационную картину мира.

Организациям необходимо срочно внедрять защиту, иначе риски в ближайшие два года могут стать катастрофическими.